爆速と噂のGroq×Llama3.1の速さを検証

Anycloudのやましたです!

AI技術の進歩が目まぐるしい最近ですが、新しいプレイヤーや技術が次々と登場していますね。

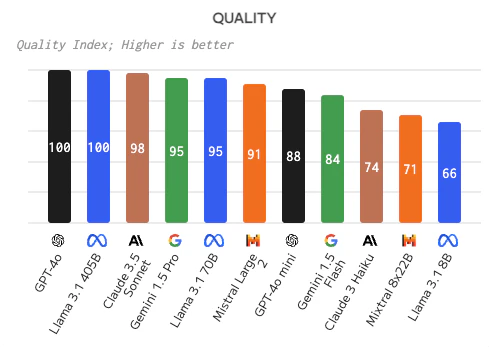

今回は、2024年7月26日時点で最もスコアの高い高精度なAIモデルの中から4つを選び、Groq×Llama3.1と速度面での比較を行いました。

精度の高いモデルは以下のサイトを参考に選択しています。

速度の比較実験

今回比較したのは以下の4つのモデルです👇

- GPT-4o(OpenAI)

- GPT-4o mini(OpenAI)

- Claude 3.5 Sonnet(Anthropic)

- Llama3.1-70b on Groq

※ Gemini Proも注目のモデルですが、速度計算が簡単にできなかったため今回の比較からは除外しています。

「日本語について1000字で説明して」という指示を与え、各モデルを何度か使い測った速度の平均を計測します。

結果

モデル | レイテンシ | 生成トークン数 | 推論速度 |

|---|---|---|---|

GPT-4o | 4.355秒 | 276 | 約63トークン/秒 |

GPT-4o mini | 7.918秒 | 276 | 約35トークン/秒 |

Claude 3.5 Sonnet | 15秒 | 1023 | 約64トークン/秒 |

Llama3.1-70b on Groq | 2.32秒 | 575 | 約250トークン/秒 |

※ レイテンシ:AIがタスクを完了するのにかかった時間

※ 生成トークン数:AIが生成したテキストの量(トークンは単語や文字の断片)

速さではGroq×Llama3.1の圧勝

Groq上で動作するLlama3.1-70bモデルは、GPT-4やGPT-4 mini、さらにはClaude 3.5 Sonnetと比べても、圧倒的な速度。わずか2.32秒で処理を完了させる性能は、他のモデルを大きく引き離しています。

特に注目すべきは、Groqの推論速度です。250トークン/秒という数字は、GPT-4の約4倍、GPT-4 miniの約6.4倍、そしてClaude 3.5 Sonnetの約3.9倍の速さになります。この速度なら、人間が読み取る速度をはるかに超えてテキストを生成できるということです。

この結果から、Groq上のLlama3.1-70bは、即時性が求められる場面で強みを発揮することがわかります。特に、リアルタイムに話したりといったようなレスポンスの速度が特に重要な場面の選択肢として最適と言えそうです。

おわりに

速度面ではGroq×Llama3.1の圧勝でした。ただし、生成されたテキストの質については、今回は詳しく触れていません。これは別の機会に検証する必要がありそうです(ただ現時点でスコアを見るとLlama3.1は十分精度が高いため、そこまで大きく変化はないと考えています)。

AI技術の進化は日々加速しています。今回の結果は、高速処理の新たな可能性を示唆するものであり、今後のAI応用分野にどのような影響を与えるのか、非常に興味深いところです。

みなさんも、機会があればGroq×Llama3.1の速さを体験してみてください!

おまけ:なぜGroqは早いのか、なぜGroq×Llama3.1なのか

Groqが超高速な理由

Groqが他のAI処理装置より圧倒的に速い秘密は、AIのために特別に作られた「LPU™」というプロセッサーにあります。

- AIに特化した設計: 普通のコンピューターの頭脳(CPUやGPU)とは違い、AIの仕事に合わせて作られています。

- メモリの工夫: データを取りに行く時間を減らすため、高速なメモリをたくさん搭載しています。これで待ち時間が大幅に減ります。

- 効率的な並列処理: AIの複雑な計算を一度にたくさん行える仕組みになっています。

つまり、AIのために作られた特別な頭脳を持っているから、Groqは超高速なんです。詳細は公式に書かれているので、気になる方はぜひ!

なぜLlama3.1と組み合わせているの?

- オープンソース: Llama3.1はオープンソースモデルです。これにより、Groqのハードウェアに最適化したカスタマイズが可能となり、性能を最大限に引き出せます。

- アーキテクチャの相性: Llama3.1のTransformerベースのアーキテクチャは、Groqのハードウェアが得意とする並列処理と非常に相性が良く、高速な処理を実現しています。

この「AIのための特別な頭脳」と「カスタマイズできる大きなAI」の組み合わせが、驚くほどの速さを実現しているんですね。今後、この高速AIがどんなことを可能にするのか、どんどん検証していきたいと思います。

Anycloudでは一緒に働くメンバーを募集しています!

Anycloudは、ユーザーの心を動かす体験を届けることを大切にしています。フルリモート・フルフレックスの環境のもと、ライフスタイルに合わせた働き方を実現しながら挑戦したい方を歓迎します。詳細はこちらをご覧ください。